Es ist kaum drei Jahre her. Am 30. November 2022 wurde ChatGPT zuerst veröffentlicht und überraschte die Öffentlichkeit durch seine Vielfältigkeit und überzeugte mit einem breiten Wissen. Es erweckte auch bei Manchen den Eindruck, es hätte eine Intelligenz oder Bewusstsein. Die Geschichte von KI ist allerdings nicht neu und nicht vom Himmel gefallen. Besonders in den 50er Jahren beschäftigte sich die Wissenschaft aber auch im Bereich des Science Fiction. Heute bewegt sich der gesellschaftliche Blick zwischen übertriebenen Erwartungen und Befürchtungen.

Anfänge

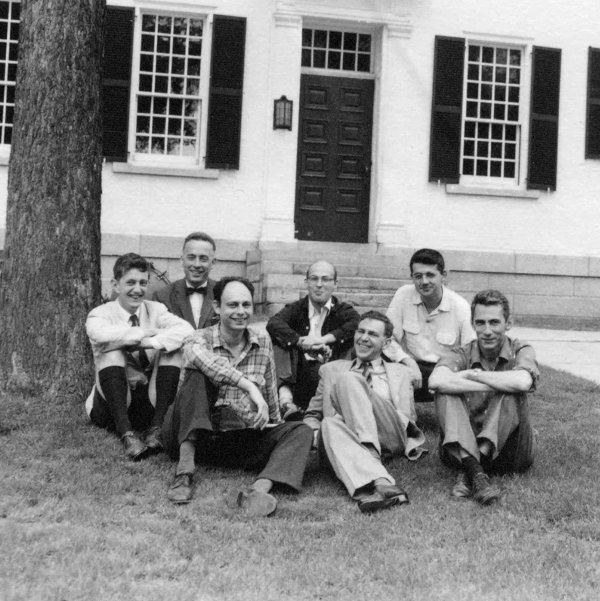

1956 wurde vom 19. Juni bis zum 26. August der Dartmouth Workshop organisiert, der als Begründung der KI-Forschung gilt. Themen waren:

- automatische Computer

- Wie muss ein Computer programmiert werden, um eine Sprache zu benutzen

- Neuronale Netzwerke

- Theoretische Überlegungen zum Umfang einer Rechenoperation

- Selbst-Verbesserung

- Abstraktionen

- Zufälligkeit und Kreativität

Zum Teil reichen Ideen von künstlichen Wesen ja bis in die Antike zurück und somit gibt es da auch Parallelen zum Traum vom Fliegen.

Frühe Erfolge

Wie oft bei „neuen“ Technologien gab es hohe und Erwartungen und übertrieben Vorstellungen. Diese wurden auch durch frühe Erfolge bei der Anwendung und den neu verfügbaren Computern begünstigt.

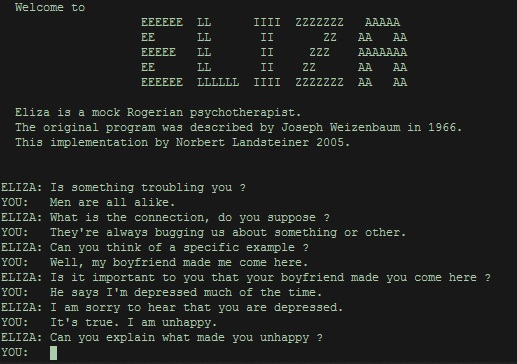

In den 60ern zB wurde das Programm ELIZA, dass ähnliche den heutigen KI-Chatprogrammen einen etwas natürlicheren Dialog mit der Software ermöglichte. Allerdings ging der Dialog (mit der simulierten Psychotherapeutin) nur bis zu einem bestimmten Punkt, an dem kritische User dann merkten, dass doch keine echte Intelligenz oder Verständnis vorlag. Aber für einige Minuten Unterhaltung reichte es aus.

In der Gesellschaft löste KI dann zunehmend auch Ängste vor einem Robot Uprising/AI Takeover oder anderen Dystopien aus - das wir alle dumm werden, das die KI die Macht übernimmt. Bekannt auch Zb Computer wie HAL im Filme 2001: „Odsyssee im Weltraum“, der um seine Missionen zu erfüllen, die Astronauten an Borden umbringt.

Prognosen

Die frühen Prognosen trafen nicht ein, sowohl die Positiven wie auch die Negativen

Aus der Wikipedia zur History of Artificial Intelligence:

The first generation of AI researchers made these predictions about their work:

1958, H. A. Simon and Allen Newell: “within ten years a digital computer will be the world’s chess champion” and “within ten years a digital computer will discover and prove an important new mathematical theorem.”

1965, H. A. Simon: “machines will be capable, within twenty years, of doing any work a man can do.”

1967, Marvin Minsky: “Within a generation… the problem of creating ‘artificial intelligence’ will substantially be solved.”

1970, Marvin Minsky (in Life magazine: “In from three to eight years we will have a machine with the general intelligence of an average human being.”

Hieran finde ich sehr wichtig, dass dieser Optimismus hier nicht etwas von Laien kam, sondern von den Top-Expert:innen auf dem Gebiet weltweit. Also Expertise-Bias/Curse of Knowledge. Dazu komme ich auch später noch einmal zu heute.

Geschichte: KI-Winter , Ups & Downs

Durch die ausbleibenden Erfolge kam es in der öffentlichen Wahrnehmung, aber auch bei der Forschung und Finanzierung zu Rückschlägen. Die Forschung wurde aber weitergeführt

Es gab mehrere KI-Winter, Setbacks, Booms, Neuausrichtingen

Für mehr Details bitte Wikipedia The history of artificial intelligence lesen!

Buzzwords

Ob nun Superintelligence, Deep Learning, Artificial General Intelligence (AGI), Large Language Models (LLM) - vor allem in den letzten Jahren machten die Maschinen einen Sprung, die zu einem neuen Hype führten, vor allem set ChatGPT und Deep Blue.

Autonomes Fahren

Ich war auch vor ein paar Jahren optimistischer, was die Anwendung des Autonomen Fahrens angeht, gerade als Tesla die Message pushte über die letzten Jahre, dass es jeweils im nächsten Jahr so weit sei, dass volle Autonomie erreicht sei.

Wie sich herausstellt gibt es aber bei den LLMs ein grundsätzliches Problem, dass eine KI bestimmte komplexe Aufgaben nur annähernd lösen kann. Das hängt zum einen mit der Qualität der Trainingsdaten zusammen. Zum anderen daran, dass die heutigen KIs kein echtes Verständnis haben von dem, was Realität ist. Ihre Antworten basieren auf einer statistischen Berechnung, welche Antwort (oder Reaktion) richtig wäre. Das heißt beim Autonomen Fahren basiert ihr „Wissen“ lediglich auf dem vorhandenen Input. Also zB Situationen, die die KI gesehen hat, oder durch Fehler gelernt hat, welche Reaktion falsch war. Es braucht dazu dann eben auch Menschen, die der KI beibringen, welche Reaktion richtig ist und welche falsch.

Das Problem ist hier also, dass alle Fehler, die nicht erkannt werden, weil es kein entsprechendes Feedback gibt (entweder dadurch, dass ein Unfall passiert, oder Menschen eine Reaktion als unerwünscht kennzeichnen), die KI auch nicht lernt.

Das führt zu dem Phänomen, dass wir seit vielen Jahren Fahrzeuge sehen können, die auf bestimmten Strecken anscheinend autonom fahren. Diese fahren dann meist langsamer und erledigen ihre Aufgaben zu mehr als 90% dann auch akzeptabel. Sie nähern sich also den 100%. Und das eben seit vielen Jahren. Autonome Busse erleben immer wieder eine Premiere.

Diese Busse haben meist noch eine Kontrollperson oder werden aus einer Zentrale überwacht. Das bedeutet also: Nicht wirklich autonom! Und die letzten Prozente zur Perfektion würden bedeuten, dass ein Fahrzeug auf alle möglichen Situationen adäquat reagieren kann. Auch die Unwahrscheinlichen. Aber genau DAS ist mit LLMs nicht möglich. Denn alles, was unvorhersehbar, kann eben auch nicht berücksichtigt werden.

Deswegen gehen auch einige KI-Expert:innen davon aus, dass eine volle Autonomie mit der heutigen Technologie nicht erreichbar ist. Ich neige auch zu der Auffassung. Es ist allerdings viel Geld im Spiel für Hochschulen und die Politik schmückt sich gerne mit der neuen Technologie und will sich zukunftszugewandt zeigen. Insofern werden da viele Milliarden versenkt und keiner fragt nach dem Erfolg. Es ist eben auch gar kein Problem, Fahrzeuge zu demonstrieren, die die Aufgabe erfolgreich erledigen. Und man sagt dann: Es muss halt „nur“ besser werden. Mit noch mehr Training.

Aber es zeichent sich eben ab, dass die nötige Perfektion momentan nicht erreichbar ist, egal wie viel Training man als Input gibt. Es gibt lediglich die Illusion von Sicherheit und Perfektion.

Ich empfehle dazu auch dieses Videointerview mit Dr. Emmanuel Maggiori:

Where do we go from here?

KIs und LLMs leisten aber schon heute sehr viel und sind faszinierend. Gerade dort, wo man ihnen nicht das Leben von Menschen in die Hände legt, kann man unbedenklicher auf ihre Fortschritte hoffen. Aber auch in manchem anderen Bereich zeigt sich, dass KIs auch Vorurteile und Rassismus derjenigen übernehmen, die sie mit Daten füttern. Einer KI Vertrauen sollte man daher meistens nicht. Aber manche Aufgaben können sie sehr schnell erledigen und man kann das Ergebnis auch überprüfen und korrigieren und können so auch Monate und Jahre an Recherche auf teilweise wenige Sekunden verkürzen.

Es ist ja auch möglich, dass in Zukunft ganz andere Systeme entwickelt werden, die die bekannten Einschränkungen nicht haben. Und es kann auch sein, dass gerade die LLMs bei deren Entwicklung befördern.

Es ist dann auch teilweise erstaunlich, wie man in Schulen auf der einen Seite die grundlegende Digitalisierung nicht hinbekommt, aber die Schüler:innen sollen das prompten lernen. Also zB können kranke Schüler:innen nach wie vor nicht den Unterricht von Zuhause aus verfolgen.

Die Wahrheit über die Zukunft liegt in der Mitte. Weder dystopische Szenarien noch „KI bringt gar nichts“ werden die Zukunft bestimmen. Skepsis und Kritik sind sehr wichtig, damit die Entwicklung nicht in die falsche Richtung geht.

_on_Google_Trends.svg.png)